1月8日下午,第二期院士大讲坛系列报告开讲。西班牙数学科学研究委员会(ICMAT)主席、西班牙皇家科学院David Rios Insua院士作题为对抗机器学习:一种对抗风险分析的视角(Adversarial Machine Learning:An adversarial risk analysis perspective) 的讲座,管理学院师生代表参与活动。报告会由管理学院教授高岩主持。

David Rios Insua院士分别从机器学习的相关理论、机器学习的安全性、对抗性机器学习理论、对抗性风险分析、ARA视角下的对抗性机器学习与挑战等方面进行阐述,探讨机器学习中的面临的安全问题。机器学习在过去十年中取得了令人瞩目的进展,使复杂的预测和决策过程实现自动化。与此同时,机器学习算法有可能会削弱机器的性能,导致重大安全问题。为应对这类问题,对抗性机器学习应运而生。对抗性机器学习主要基于博弈论概念,而博弈论的概念在安全领域中难以合理应用。

高岩主持

如何分析出“学校—机器学习—人工智能”这三者之间的联系和区别?首先,机器学习方法包括监督学习、无监督学习和强化学习。其次,基于逻辑和知识的方法包括知识表示、归纳(逻辑)编程、知识库、推理和演绎引擎、(符号)推理和专家系统。最后,统计方法包括贝叶斯统计、搜索和优化方法。发现(有用的)新分子、改进药物发现过程、自动驾驶系统、情感社交机器人及人格模型的逆向工程,这些都是机器学习的应用实例。

David Rios Insua院士作报告

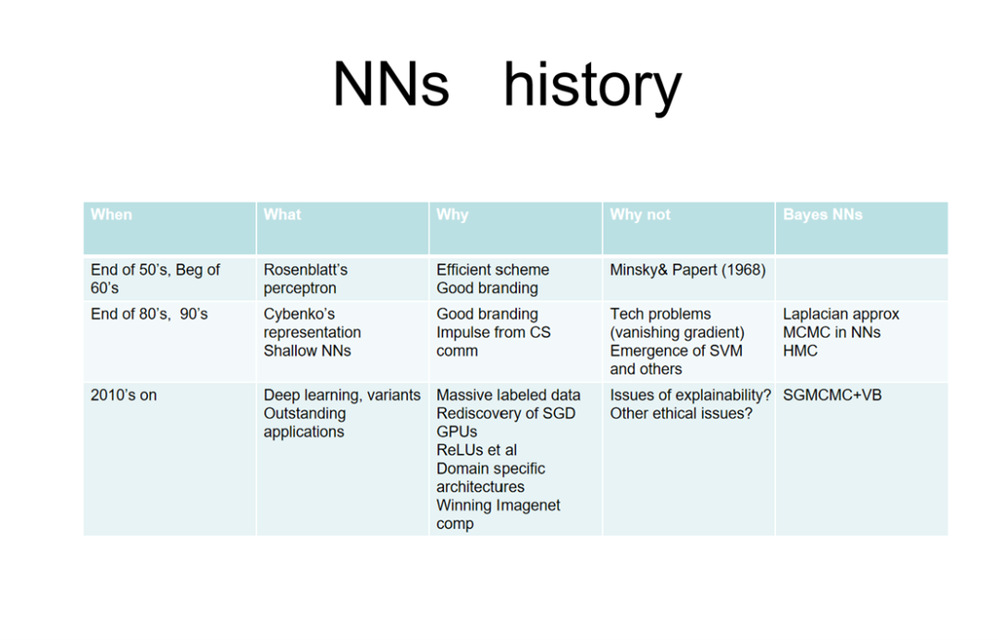

此外,David Rios Insua院士还论述了神经网络的历史。

在机器学习的测试中,通常需要检测模型的准确性、鲁棒性、安全性、数据隐私性、效率、公平及可解释性。准确性测试是验证模型的预测结果与真实结果间的差异,研究者通常会将数据集分为训练集和测试集,用训练集来训练模型,使用测试集来评估模型的准确性。鲁棒性测试的目的是测试模型对于异常值、噪声和其他意外情况的处理能力,通过对模型进行鲁棒性测试来评估其对于不确定性的处理能力。

报告现场

对抗性机器学习所面临的问题有其针对性的解决方法。分析机器学习呈现出系统及攻击漏洞,针对此类攻击,有安全评估、保障等方法。最后,David Rios Insua院士向大家提出系列问题,如传统的统计、机器学习、风险分析及受到对手干扰应如何处理?讨论环节,师生踊跃发言,现场气氛热烈。

交流互动